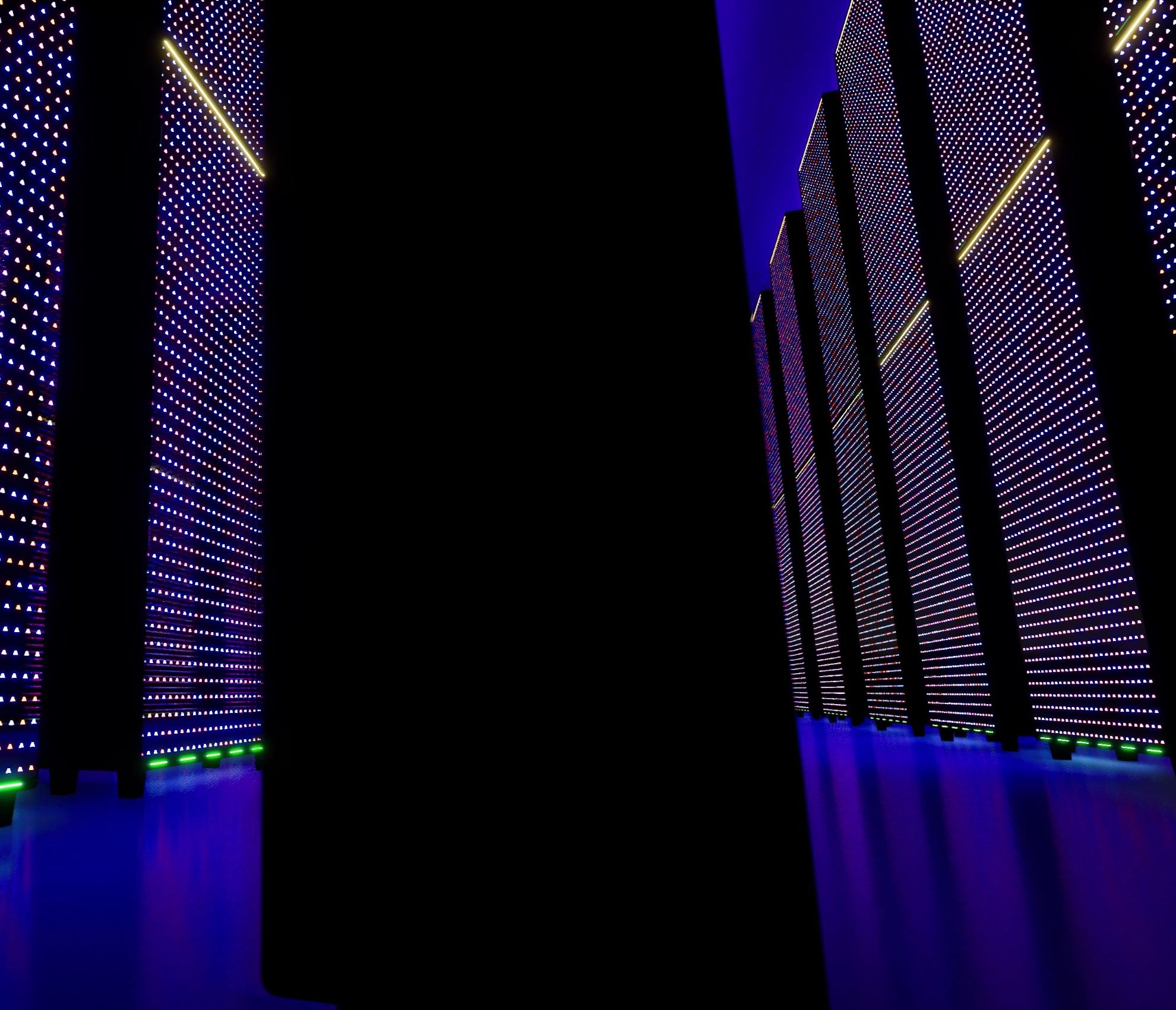

Omniprésente dans toute organisation, l’information est indispensable à l’activité des entreprises. Avec l’arrivée d’internet, des forfaits mobiles et illimités, des nouvelles technologies, etc., les volumes des flux de données sont devenus conséquents, et même massifs. Mais désormais, la collecte des informations ne suffit plus, leur stockage et leur analyse constituent la plus-value et l’intérêt même de leur collecte. Voilà ce qu’est le Big Data : des techniques permettant de stocker et traiter les données de masse.

L’intelligence de la donnée, ou le management du Big Data doit donc permettre l’analyse et l’exploitation des données afin d’en tirer les informations essentielles (comme le comportement des consommateurs) pour l’activité de l’entreprise et plus précisément la prise de décisions stratégiques.

Pour que ces opérations soient performantes et efficientes, le Big Data suppose le recours à des solutions adaptées à la gestion d’informations massives et variées. Zoom sur les solutions technologiques à la disposition des entreprises.

Les enjeux des outils de management du Big Data

Le Big Data est un concept pour qualifier les volumes de données conséquents produits. En effet, plus de 29 000 Giga-octets de données sont produits chaque seconde dans le monde, et ces informations proviennent de nombreuses sources (publications sur les réseaux sociaux, données transactionnelles d’achats sur internet, informations de connexion, cookies, mails, objets connectés, données GPS, etc.).

Pour tirer avantage du Big Data, il faut savoir exploiter le volume et la pertinence des informations. En effet, ces données ont une valeur intrinsèque pour les entreprises, pour :

- développer de nouveaux produits ou services en adéquation avec les besoins du marché ;

- comprendre le comportement et les attentes des consommateurs pour gagner en performance et fidéliser les clients ;

- proposer le bon produit ou offre promotionnelle au bon client ;

- recruter des profils spécifiques ou des compétences rares ;

- prévoir les ventes ;

- gérer les stocks ;

- etc.

Cependant, une telle gestion ne peut être mise en œuvre avec les outils classiques. C’est pourquoi de nouvelles solutions sont développées de manière continue. Pour cela, les outils de traitement du Big Data doivent intégrer 3 objectifs indispensables, couramment appelés les « 3V du Big Data ».

- Le volume des données puisque le Big Data suppose le traitement de gros volumes d’informations non structurées, nécessitant la mise en place d’architectures adaptées ;

- La variété des données, car elles proviennent de n’importe quelle source (texte, audio, vidéo, photo, image, etc.) impliquant un traitement spécifique ;

- La vitesse de collecte, de stockage et de traitement des données reçues selon le mode de traitement retenu.

Outre l’intérêt commercial que représente le Big Data, il y a aussi un enjeu en matière de sécurisation des données. En effet, les informations ne sont pas sécurisées tant qu’elles n’ont pas été analysées et stockées (il s’agit des Dark Data). Quand on sait qu’à peine 1 % des informations collectées sont analysées par les entreprises aujourd’hui, on comprend mieux les risques liés au Big Data et la nécessité de traiter un maximum de données.

Apache Hadoop, l’écosystème de gestion historique du Big Data

Apache Hadoop est la toute première solution développée au commencement du Big Data pour le stockage et le traitement des gros volumes de données. Il s’agit d’un framework logiciel open source proposant un écosystème complet de technologies et de composants et réputé notamment pour :

- son système de stockage HDFS ;

- son gestionnaire de ressources et des tâches YARN ;

- son moteur d’analyse unifié Spark ;

- sa solution de traitement parallèle des grands ensembles de données (traitement par nœuds) MapReduce ;

- sa base de données NoSQL HBase ;

- etc.

Grâce à ses packages logiciels basiques (AWS Elastic Compute Cloud ou AWS Elastic MapReduce par exemple), Hadoop est compatible avec les environnements variés des entreprises et des fournisseurs de stockage Cloud. De plus, en cas de panne d’un des nœuds de traitement, les données sont transférées vers un autre nœud.

Néanmoins, la plateforme Hadoop présente certains inconvénients, comme son exploitation complexe liée à l’agrégation par surcouche des différents composants au fur et à mesure des mises à jour, son utilisation limitée lorsque l’environnement de l’entreprise ne prend pas en charge le traitement des données en parallèle ou encore son inadéquation avec le traitement de petites données.

Enfin, Hadoop souffre également d’une certaine vulnérabilité dans la mesure où le code de programmation utilisé est le Java, le langage le plus populaire et utilisé dans le monde et donc bien connu des hackers et autres cybercriminels, ainsi que par la désactivation par défaut des mesures préventives de sécurité.

Solution technologique complète et performante, Hadoop est surtout réservé aux très grandes entreprises disposant d’un haut niveau de compétence technique nécessaire à son utilisation.

Les nouvelles solutions sur le marché de l’intelligence de la donnée

Les solutions technologiques en matière d’intelligence de la donnée ne cessent de se développer. Outre la dimension volumétrique (gestion de gros volumes de données), elles doivent intégrer la notion de vitesse de traitement et la nature variée des informations collectées (les 3V). C’est pourquoi toute architecture Big Data (ou écosystème) intègre plusieurs solutions.

Tout d’abord, l’architecture doit comporter une solution de collecte et/ou de préparation (comme Open Refine) des données massives non structurées reçues permettant de classer les informations pour un traitement et un stockage appropriés à leur nature, comme c’est notamment le cas avec les bases de données analytiques NoSQL de type Apache Cassandra ou MongoDB.

En effet, l’avantage des bases de données analytiques NoSQL (not only SQL) est de gérer une grande variété de données (texte, photo, vidéo, mail, etc.) et de permettre un stockage en colonne (et non horizontal) pour une compression plus efficace.

Quant aux solutions de traitement à mettre en place dans l’architecture Big Data, elles doivent être choisies au regard des attentes de l’entreprise, mais surtout de son mode de fonctionnement.

- Le traitement de l’information de type Batch permet de traiter les données en continu et de manière incrémentielle (par lots), c’est-à-dire une analyse des nouvelles données sans réanalyser les données déjà traitées. Cependant, les résultats de traitement ne sont accessibles qu’en fin de processus afin d’assurer une cohérence entre les données. Parmi les solutions sur le marché, Spring et MapReduce sont les plus fréquemment utilisés.

- Le traitement de l’information en temps réel (ou streaming) fonctionne sur le principe opposé au type Batch puisqu’il permet d’obtenir le résultat à n’importe quel moment de l’analyse des données grâce à un traitement par flux. Les principales solutions utilisées sont Spark de Apache et Storm créé par Twitter.

Certains outils proposent une solution hybride permettant un traitement en temps réel et une analyse de flux par lots ou nœuds, comme Apache Storm. Il est également possible d’implémenter une solution de « machine learning » pour un apprentissage automatique grâce à des algorithmes et à l’Intelligence Artificielle, comme le leader Mahout d’Apache.

Enfin, l’ensemble de ces composants ne peuvent être intégrés dans l’architecture et fonctionner sans une technologie d’orchestration. Azure est un orchestrateur de données qui permet, en outre, d’automatiser les tâches répétitives et de planifier les opérations à effectuer.

Nous vous recommandons ces autres pages :

Des questions ?

Contactez-nous dès aujourd’hui pour discuter de vos projets IT et découvrir comment nous pouvons vous aider à les réaliser avec succès.